Ivo Pilving

Riigikohtu halduskolleegiumi esimees, Tartu Ülikooli haldusõiguse dotsent

Monika Mikiver

Justiitsministeeriumi avaliku õiguse talituse nõunik, Tartu Ülikooli õigusteaduskonna doktorant

Tehisintellekti rakendused jõuavad erasektori „neljanda tööstusrevolutsiooni“ kõrval järjest enam ametnike kabinettidesse. Ka Eestil on ambitsioon asuda riigihalduses laialdaselt rakendama roboteid ehk kratte, mis toetavad või asendavad ametnikke.[1] Avaliku sektori kratid on Eestis saanud vaid õige põgusat õigusteaduslikku tähelepanu,[2] ehkki mõne valdkonna (maksukorraldus, keskkonnatasud, töötuskindlustus) seadustes kehtestati juba 2019. aastal volitused automaatsete haldusaktide andmiseks.[3] Juuniks 2020 on kavas Riigikogule esitada eelnõu, mille vastuvõtmisel tehtaks kehtivasse õigusesse, sh haldusmenetluse seadusesse (HMS), tehisintellekti ulatuslikumaks kasutuselevõtuks vajalikud muudatused.[4]

Ajakirjanduses on olnud muu hulgas juttu automaatsest pensionide maksmisest ja töötute arvelevõtmisest.[5] Tasub tähele panna, et kõik e-riigi lahendused ei põhine tehisintellektil, paljudel juhtudel on tegemist andmetöötluse lihtsamate automaadistatud vormidega. Tõsi, haldusõiguse põhimõtete kohaselt võivad seadusega pahuksisse sattuda ka täielikult inimese juhitavad, kuid vigaselt toimivad lahendused. Eriti suur väljakutse aga on tehisintellekti, ennekõike iseõppivate algoritmide allutamine õigusele. Lohaka ja pahatahtliku rakendamise korral satuvad kratid kergesti konflikti ausa menetluse reeglitega, rikuvad seadust ning kohtlevad inimesi ja ettevõtjaid meelevaldselt. Kratid ei oska praegu veel oma otsuseid seletada.

Et kratiprojekt õnnestuks ega tooks kaasa suuri ühiskondlikke ning äririske, tuleb e-riigi arendamisel mõista nii masinõppe olemust kui ka selle mõju haldus- ja kohtumenetlusele.[6] Joobnu õhinaga toimetamine selles vallas oleks samaväärne riigivõimu teostamisega horoskoobi alusel. Naiivne ja ohtlik oleks lasta lummata end illusioonist, et kratt suudab juba või hakkab kohe varsti suutma mõistuslikult arutleda ning hoomata inimkeele, sh õigusteksti sisu. Õiguse õige rakendamine eeldab nii ratsionaalsust kui ka õiguse mõistmist sellest arusaamise tähenduses. Kui riske osatakse näha ja arvestada ning krattidele leitakse õiged tegutsemisnišid, jätkuks neile riigihalduses tööd üksjagu ja neist võib tõusta kasu nii otsuste tõhususele kui ka kvaliteedile.

Selle kirjatöö fookuse hoidmiseks jätame kõrvale algoritmide kasutamise andmekaitseõiguslikud aspektid,[7] kuigi neil on haldusõigusega oluline ühisosa. Vaatleme algoritme sõltumata sellest, kas otsuseid langetatakse füüsilise või juriidilise isiku kohta ning kas see toimub isikuandmete või muude andmete alusel. Artikli maht ei võimalda sügavuti uurida võrdse kohtlemise probleemi. Artiklis tuuakse lugejani esmalt mõned näited krattide rakendamisest avalikus halduses (1), püütakse seejärel selgitada algoritmiliste haldusotsuste tehnilist olemust (2) ning uuritakse lõpuks haldusõiguse printsiipide toimimist sedalaadi otsuste tegemisel (3). Artikli põhiküsimus on, kas ja millal saab kratti õpetada seadust lugema ja järgima, sest riigivõimu seaduslikkust progressile ohvriks tuua ei või.

1. Algoritmid avalikus halduses

Tehisintellekti entusiastid nii meil kui ka mujal osutavad, et krattide rakendamise korral avanevad kulude kokkuhoiu, tootlikkuse suurendamise ja ametnike rutiinsetest ülesannetest vabastamise laialdased võimalused.[8] Järjest võimsam arvutipark ja üha nutikam tarkvara suudab töödelda pööraseid andmehulki ning lahendada inimesele üle jõu käivaid ülesandeid. Avalik sektor peab erasektoriga sammu pidama. Muu hulgas võivad algoritmid osutuda avalikus halduses vajalikuks, et tõhusalt ohjata tehisintellekti kasutamist äris, näiteks automaatseid börsitehinguid.[9]

Avaliku halduse nutikaid süsteeme on võimalik liigitada järgmistesse kategooriatesse: inimestega suhtlemine,[10] asutusesisene tegevus,[11] otsuste ettevalmistamine ja otsuste langetamine. Meid huvitavad siinses artiklis peaasjalikult kaks viimast kategooriat. Eestis rakendab õppivaid algoritme näiteks Põllumajanduse Registrite ja Informatsiooni Amet satelliidipiltide analüüsimisel, et kontrollida rohumaade niitmise kohustuse täitmist. Tallinna linnavalitsus mõõdab masinnägemise abil liiklusvooge. Siseministeerium soovib automaadistada järelevalvet üleriigilise näo- ja numbrituvastusfunktsiooniga kaamerate võrgu abil. Töötukassa loodab lähitulevikus rakendada tehisintellekti näiteks töötuse riski hindamiseks.[12]

USA-s määrab algoritm peretoetusi ja analüüsib riske, mis võivad õigustada lapse eraldamist perest.[13] Algoritme on seal rakendatud näiteks sissesõidukeeldude kehtestamisel, vangide ennetähtaegsel vabastamisel, vahistamisel ja kautsjoni kohaldamisel, terrorismivastases võitluses, söögikohtades kontrollkäikude kavandamisel jne. Ennustatakse tehisintellekti peatset rakendamist näiteks lennukipiloodi litsentside andmisel, maksu tagastusnõuete hindamisel või kinnipeetavate jaotamisel vanglate vahel.[14]

Algoritmidel põhinevat ennetava politseitöö (predictive policing) süsteemi kasutakse nii USA-s kui ka Saksamaal õigusrikkumiste aja, koha ja toimepanijate prognoosimiseks. Süsteem analüüsib kuritegevuse statistikat, aga ka kaamerate ja droonide jälgimissalvestusi, et tunda ära teatud rikkumiste esinemismustreid ja suunata saadud teadmiste abil operatiivjõude. Vaidlused algoritmide kasutamise üle on jõudnud juba ka Euroopa riikide kõrgematesse kohtutesse, näiteks Prantsuse ja Hollandi riiginõukogude ette, seoses ülikoolidesse kandideerimise ja keskkonnalubade väljastamisega.[15]

2. Tehniline taust

2.1. Põhimõisted

Tehisintellekti mõistmiseks tuleb esmalt avada mõned andmeteaduse mõisted, mille täpses määratluses pole kaugeltki üksmeelt.[16] Püüame ühe võimaliku ülevaate siiski anda.

Tehisintellekti võib mõista kui arvutisüsteemi võimet täita ülesandeid, mida üldiselt seostatakse inimmõistusega, näiteks infost aru saada ja seda jälgida, suhelda, arutleda ning õppida. Neid tehisintellekti omadusi tuleb käsitada metafooridena funktsionaalses tähenduses, sest näiteks masina „õppimine“ ei ole tegelikult samane inimese õppimisega. Tehisintellektil on palju harusid: automaatne otsustustugi, kõnetuvastus ja -süntees, pildituvastus jt. Kratt on tehisintellekti rakendus – intelligentne süsteem.[17]

Andmekaeve on protsess, mille käigus ekstraheeritakse suurtest andmestikest (massandmetest) statistiliste meetodite abil uusi teadmisi: üldistusi, seoseid andmete vahel ja korduvaid mustreid.[18] Mitmesugused statistilised meetodid on analüütikutel juba varem võimaldanud luua andmehulkade alusel matemaatilisi mudeleid, et kirjeldada looduses või ühiskonnas toimuvat. Nende abil on omakorda võimalik hinnata ja klassifitseerida uusi olukordi ning ennustada tulevikku, näiteks ilma või kurjategija retsidiivsust. See on eriti tõhus, kui kasutada mudeldamiseks iseõppivaid algoritme (masinõpet).[19]

Algoritm on täpne matemaatiliste või loogiliste instruktsioonide kogum, üldisemalt igasugune etapiviisiline tegevusjuhis kindla ülesande lahendamiseks (ka nt koogiretsept). Algoritmi esitus programmeerimiskeeles on arvutiprogramm. (1) Algoritme, mille tööparameetrid määrab täielikult inimene, eristatakse (2) algoritmidest, mis muudavad oma parameetreid autonoomselt, õppimise käigus.[20] Avaliku halduse traditsioonilised otsustusprotsessi automaadistavad süsteemid (eksperdisüsteemid) põhinevad esimestel. Kratid rajanevad valdavalt õppivatel algoritmidel (vahel ka keerukamatel mitteõppivatel algoritmidel).

Masinõpe on protsess, mille korral tehisintellektisüsteem täiustab oma talitust, omandades uut teadmust või uusi oskusi või neid ümber korraldades. Seda iseloomustab õppivate algoritmide abil olukordade hindamine või prognooside tegemine (nt diagnooside panemine, krediitkaardipettuste tuvastamine, kuritegude ennustamine). Eri omadustega masinõppetehnikaid on hulgaliselt: lineaarne ja logistiline regressioon, otsustuspuu, otsustusmets, tehisnärvivõrgud jne.[21] Levinuima, juhendatud õppe korral treenitakse algoritmi esmalt õpiandmetega – suure hulga andmejuhtudega, mille korral on teada nii sisendväärtused (nt maksekäitumise andmed) kui ka väljundväärtus (nt maksevõime).

Hilisemas tööetapis peab rakendus uute juhtumite väljundväärtused juba ise sisendandmete põhjal välja arvutama. Need võivad olla esitatud arvandmetena (regressioon) või ka näiteks „jah/ei“-vastustena (klassifikatsioon). Õppiva algoritmi tuumikelement on selles sisalduv optimeerimis- või eesmärgifunktsioon. See on algoritmi ülesande matemaatiline väljendus, mis sisaldab hulka nn kaaluparameetreid.[22] Õppides otsib kratt võimalikke kaalude kombinatsioone ja valib edasiseks töömudeliks välja sobivaima, sellise, mille lahendid kalduvad kõige vähem kõrvale õpiandmete seostest. Neid operatsioone korratakse sadu, tuhandeid või isegi miljoneid kordi.[23]

Automaatse haldusotsuse all peame siin silmas igasugust haldusasutuse otsust, mille ettevalmistamisel või tegemisel kasutatakse automaadistamist. See võib rajaneda nii lihtsamatel või keerulisematel mitteõppivatel algoritmidel (ekspertsüsteemidel) kui ka masinõppel.[24] Näiteks maamaksu teade koostatakse täielikult reegli järgi, siin ei toimu mingisugust arvuti nutikat isetegevust.

Algoritmiliste haldusotsuste all mõistetakse kitsamalt just tehisintellekti abil tehtavaid otsuseid. Automaatsed haldusotsused saab jagada veel täis- ja poolautomaatseteks. Viimased peab ametnik kinnitama. Vahel otsustab arvuti ette antud kriteeriumide alusel, kas tal on võimalik langetada lõplik otsus, näiteks maksu tagastusnõude rahuldamine, või tuleb jätta asi ametniku otsustada.[25] Mõnikord kasutatakse automaatsete ja algoritmiliste otsuste mõisteid sünonüümidena, tihti ongi need omavahel kombineeritud, kuid tuleb arvestada, et tehisintellekti õppimisvõime toob avalikus halduses rakendamisel kaasa nii lisavõimalusi kui ka -probleeme.[26]

2.2. Masinõppe põhiomadused

Iseõppivate algoritmidega saab töödelda triljoneid andmejuhtumeid, millest igaühte iseloomustavad kümned tuhanded muutujad. Ka Eestis on mõned asutused juba mõnda aega koondanud analüüsi eesmärgil andmeid suurtesse andmeladudesse.[27] Masinõpe ei muuda aga andmeanalüüsi põhiolemust, vaid võimendab seda: masinõpe (oma praeguses võimekuses) suudab avastada vaid statistilisi seoseid. Need ei ole olemuselt kausaalseosed, ka mitte loodusteaduslikud või juriidilised suhted. Olenevalt mudeli rafineeritusest võivad masinõppe väljundandmed mõnes olukorras siiski hämmastavalt täpselt peegeldada tegelikku maailma ja aimata ette tulevikku. Suurem või väiksem veaprotsent aga jääb tõenäosusarvutuste korral alati alles.[28]

Õppivad algoritmid ja õppimise käigus loodavad mudelid on mahukad ning keerulised, seetõttu ei pruugi inimene, ka mitte kogenud informaatik ega isegi algoritmi looja, suuta masinõppe rakenduse tööd jälgida ega seletada (läbipaistmatus ehk musta kasti efekt). Mida tõhusam on algoritm, seda läbipaistmatum see on. Jälgida on võimalik keeruka masinõppesüsteemi üksikuid elemente, näiteks otsustusmetsa üksikuid puid. See aga ei võimalda just paljut järelda protsessi kui terviku kohta. Läbipaistmatus on mõnikord lausa soovitav, et kaitsta isikuandmeid või ärisaladust, või vältida seda, et otsuse adressaat algoritmi üle kavaldab.[29]

Masinõppe statistilise iseloomu tõttu on selle õpetamiseks tarvis väga suuri andmehulki. Paraku või pigem õnneks on näiteks terroriaktide kohta liiga vähe andmeid, et nende prognoosimiseks täpseid hinnanguid anda.[30] Andmete kvantiteedi kõrval pole sugugi vähem tähtis nende hea kvaliteet ja standardsus: tõesus, asjakohasus, korrastatus, ühilduvus, igakülgsus, kõikehõlmavus, erapooletus ning iseäranis turve. See kehtib nii õpiandmete kui ka algoritmi tegelikul rakendamisel kasutatavate tööandmete kohta. Kõik masinõppe ennustused põhinevad õpiandmetel ja senisel kogemusel. Taas üks masinõppe kuldreegel: rämps sisse, rämps välja. Halva andmekvaliteedi korral võivad tekkida mitmesugused moonutused, muu hulgas sellest, et ei suudeta, ei peeta oluliseks või majanduslikult mõttekaks uurida kõiki hindamist mõjutavaid tegureid.[31] Samal ajal võimendab otsuste suur hulk veaprotsendi mõju absoluutskaalal.

Masinõppe käigus välja töötatavaid mudeleid ja otsuseid pole võimalik täielikult ette näha ega suunata.[32] Sellele vaatamata on inimestel – programmeerijatel, analüütikutel, andmeteadlastel, süsteemiarendajatel ning lõpuks ka targal kasutajal – ulatuslik roll ja vastutus seoses masinõppe tulemuste kvaliteediga. Lõpptulemust mõjutavad kõikvõimalikud strateegilised otsused ja peenhäälestused: asjakohase väljundmuutuja defineerimine,[33] eesmärgifunktsiooni loomine, algoritmi tüübi valik ja väljaarendamine, algoritmi häälestamine ettevaatlikumaks või julgemaks, testimine ja auditeerimine. Kaks eri tüüpi algoritmi, mis kumbki on eraldi võetuna väga täpsed, võivad anda samale kaasusele erinevaid vastuseid.[34]

3. Robotriik või e-õigusriik?

Eespool osutatud masinõppe tehnilised eripärad tekitavad avalikus halduses märkimisväärseid õiguslikke väljakutseid. Masinõpe võib statistiliselt anda suurepäraseid tulemusi, kuid üksikjuhtudel võib palju ka valesti minna.

3.1. Halduskorralduslikud ohud: digitaalne delegeerimine ja privatiseerimine

Riigivõimu volitusi võib kasutada vaid selleks pädev asutus. Ta võib selleks kasutada ka automaatsete seadmete, näiteks valgusfoori või arvuti abi. Mida suurem otsustusvabadus algoritmile jääb, seda aktuaalsemaks muutub küsimus, kas otsustamine allub tegelikult pädeva asutuse kontrollile või kulgeb hoopis isevoolu teed.[35] Formaalselt võib otsuse meie arvates siiski alati algoritmi kasutavale asutusele omistada, ta jääb selle eest õiguslikult vastutavaks. Suure otsustusruumi korral tekib hoopis sisuline probleem: kas asutus suudab krati panna kõiki olulisi üksikasju piisavalt läbi mõtlema.[36]

Võib eeldada, et riigil tekib praktiline vajadus delegeerida oma algoritmide arendamine suures osas erakapitalil rajanevatele IT-firmadele. Siin on vaja jälgida, et ei kaoks demokraatlik kontroll algoritmi tööd vahetult juhtivate ettevõtjate üle, näiteks et nad ei omandaks täielikku võimu haldusotsuste sisu üle ega maksimeeriks oma kasumit haldusotsuste kvaliteedi arvelt. Järelikult tuleb e-riigi arendamisel analüüsida, kas praegune riigihanke- ja halduskoostööõigus maandab need riskid piisavalt.[37]

3.2. Erapooletus

Inimesed on aastakümneid lootnud, et tehisintellekti abil on võimalik luua eelarvamustest vaba, omakasupüüdmatu ja mugavustsoonita otsustaja, kes kohtleb kõiki võrdselt. Paraku on tegelikkus näidanud masinõppel tõsiseid raskusi nn kallutatuse probleemiga. Tehisintellekt kipub sisendandmete või algoritmi ebapiisava kvaliteedi korral mõningaid inimrühmi diskrimineerima, näiteks selle tõttu, et mõnd inimrühma on varem teistest enam jälgitud ja see peegeldub õpiandmetes, mille abil kratti treeniti (nt mustanahalised USA-s ennetava politseitöö või retsidiivsuse hindamise süsteemides).[38]

3.3. Seaduslik alus

Põhiseaduse (PS) § 3 lg 1 ls 1 järgi tohib riigivõimu teostada üksnes seaduse alusel. Küsimusele, kas ja kuidas peab seadusandja täitevvõimu asutustele masinõppe rakendamiseks volituse andma, ei saa vastata lihtsalt ega ühtmoodi. Kui masinõpet rakendatakse vaid haldusotsuse ettevalmistamiseks (nt keskkonnaloa andmise korral mõne saastenäitaja prognoosimiseks), ent lõpliku haldusotsuse mõtleb läbi inimesest ametnik tavapäraseid menetlusreegleid järgides, võib masinõppe abi pidada haldusmenetluse üksikasjaks, mille määramisel on haldusorganil suur otsustusruum (HMS § 5 lg 1) ning mis ei vaja spetsiaalset volitusnormi.[39]

Kui inimese roll otsuse tegemisel hääbub kummitemplile omaseks või kaob sootuks, võib tegu olla parlamendi heakskiitu vajava küsimusega. Igas valdkonnas (tegevusload, sotsiaaltoetused, keskkonnakaitse, korrakaitse, sisseränne jne) tekivad intelligentsete süsteemide ulatuslikul rakendamisel spetsiifilised probleemid, mis vajavad eraldi otsustamist ja tasakaalustamist asjakohaste sisuliste ning protseduuriliste garantiidega.[40] Peale juriidiliste probleemide oleks siin tark läbi mõelda riigirahanduslikud riskid: kas kratile kolme veretilga andmine ei muuda seadusandjat krati orjaks. Kallis ja keeruline rakendussüsteem võib hakata takistama seaduste muutmist ning poliitilise tahte elluviimist.[41]

Maksukorralduse seaduse (MKS) § 462 lg 1 alusel on täitevvõimule antud lai volitus automaatse, ilma ametniku sekkumiseta haldusotsuste tegemiseks maksukorralduse valdkonnas. Täpsema loetelu peab kehtestama rahandusminister.[42] Seaduses ei nähta ette piiranguid otsuste tüüpidele ega laadile, mida võib automaadistada. Maksukorralduse valdkonda peetakse üsna täpse õigusliku määratletuse tõttu automaadistamiseks pigem sobivaks. Siin ei pruugi läbimõeldud tuginemine laiale volitusnormile anda lubamatuid tulemusi. Totaalse üldvolituse andmine[43] mis tahes haldusotsuse tegemiseks täisautomaatse otsusena võib aga kaasa tuua PS-i § 3 lg 1 ja § 14 rikkumise.

3.4. Seaduse ülimuslikkus

Põhiseaduse § 3 lg 1 lausest1 tulenevalt võib riigivõimu teostamisel algoritmist juhinduda vaid siis, kui see vastab igal rakendushetkel täpselt seadusele.[44] See aga eeldab, et inimene või iseõppiv süsteem suudab seaduse teisendada algoritmiks. Mõnelgi juhul oleks see põhimõtteliselt võimalik, kuigi tihti väga mahukas töö, mis eeldab arendajalt samal ajal nii infotehnoloogilisi, matemaatilisi kui ka juriidilisi süvateadmisi.[45] Suurt osa õigusnorme aga ei ole võimalik kirjeldada algoritmile omaste ühemõtteliste muutujatena.[46] Seda nii õiguse esitusvahendi – inimkeele – paratamatu ebamäärasuse kui ka taotluslike lõtkude tõttu, et tagada paindlikkus.[47]

Õigus kasutab sammsammuliste instruktsioonide (konditsionaalprogrammide) asemel sageli hoopis finaalseid programme:[48] üldsõnalisi eesmärke, näiteks elukeskkonna parandamise, avalikkuse kaasamise ja teavitamise, huvide tasakaalustamise ja lõimimise, teabe piisavuse, otstarbeka, mõistliku ja säästliku maakasutuse põhimõtted (planeerimisseaduse §-d 8–12); kaalutlus- ehk diskretsioonivolitusi, näiteks korrakaitseasutuse õigus teha vastutavale isikule ettekirjutus ohu tõrjumiseks või korrarikkumise kõrvaldamiseks (korrakaitseseaduse – KorS – § 28); määratlemata õigusmõisteid, näiteks ülekaalukas avalik huvi (veeseaduse § 192 lg 2), oht (KorS § 5 lg 2); üldpõhimõtteid, näiteks inimväärikus, proportsionaalsus, võrdne kohtlemine (PS § 10, § 11 ls 2 ja § 12).

Juriidilised subsumptsioonid[49] (nt seaduse rakendamisel vajalikud otsustused, kas objekt on ehitis ehitusseaduse mõttes, kas isik on hankija riigihangete seaduse tähenduses, kas tegu on kestva tegevusega maaelutoetuse andmisel või kuidas piiritleda kaubaturg konkurentsijärelevalves) ei ole õiguse ebamäärasuse tõttu pelgalt formaalloogilised tehted, vaid nõuavad hinnanguid. Enne olukorra lahendamist tuleb otsustajal normi tõlgendada, et selgitada, kas seadusandja soovis või ei soovinud olukorra normile allutada. Enamgi veel, otsus tuleb teha ka olukordades, mille peale seadusandja ei osanudki mõelda, näiteks uus piiripealne maksude vältimise skeem. Siin on rakendajal tarvis hinnata, kas tegemist on lubatava optimeerimise või kuritarvitusega (MKS § 84). Nii tõlgendamisel kui ka lünkade täitmisel jätkavad seaduse rakendajad – ministrid, ametnikud, kohtunikud, lepingupooled – parlamendi alustatud reguleerimisprotsessi. Nad peavad seadust konkretiseerima.[50]

Tuleb tõdeda, et siin ilmneb mõningane sarnasus masinõppega: ka õppiv algoritm ei ole inimese loodud kujul veel lõplikult valmis, vaid arendab ennast edasi ning on võimeline just nimelt olukordade klassifitseerimiseks looma mudeleid. Kas siis seadusandja tegelikku tahet ei saaks sel viisil mudeldada? Kas see pole tavapärane nutikale süsteemile jõukohane klassifitseerimisülesanne umbes nagu kassipiltide tuvastamine? Paraku ei saa masinõppe lähtematerjal – minevikust pärit andmed – põhimõtteliselt olla küllaldane seaduse kui koodi edasiarendamiseks.[51] Ka seaduse rakendaja peab arvestama senist kohtu- ja halduspraktikat[52] ning sealt välja kristalliseeruvaid üldistusi, kuid sellega ei tohi tema allikad piirduda.[53]

Ametnik ja kohtunik peavad suutma tajuda, mõtestada ning rakendada palju laiemat konteksti: seaduse sünnilugu, normide süstemaatikat, seaduse eesmärki ja õiguse üldist mõtet, eriti aga seaduse rakendusotsuse otseseid ning kaudseid mõjusid. Õiguse ja selle toimimiskeskkonna kõigi kihistuste kirjeldamiseks ei ole igas valdkonnas võimalik luua kvantitatiivselt ega kvalitatiivselt piisavat andmestikku. Ammugi ei ole (praegustel) nutikatel süsteemidel võimalik kogu seda mateeriat reaalajas jälgida. Seepärast on paljudes olukordades tarvis mõistuslikku olendit, kes saab aru reguleerimist vajava üksikolukorra iseärasustest ning loob selle jaoks vajaduse korral uut õigust, mitte ei jää seda otsima varem läbi proovitud mustritest.[54]

Õigusmõistete kui loomuliku keele mõistete ähmasus pole õiguse puudus. Õiguse üle peabki saama vaielda, et saavutada konkreetsetes olukordades õiglane otsus. See aga eeldab avatud ja ausat diskussiooni erinevate tõlgenduste ning faktide hindamise võimaluste üle. Ka siis, kui tõlkida seadus nullide ja ühtede keelde, pole seaduse tõlgendamisest pääsu. See nihkub vaid otsuse tegemise etapist (1) eksperdisüsteemi loomise ja häälestamise või (2) intelligentse süsteemi õppimise etappi.[55] Kummalgi juhul puuduks vähemalt puudutatud isikutel, eelduslikult ka pädeval haldusorganil (arvestades masinõppe keerukust) tõhus võimalus tõlgendamisel kaasa rääkida. Iseõppiva algoritmi otsused on keerukuse tõttu struktuurselt ennustamatud, mitte pelgalt raskesti ennustatavad.[56]

Kuidas tagada, et õppides ei hälbiks algoritm seadusest? Aeg-ajalt toimuv testimine ja auditeerimine ei ole piisav lahendus, sest ka testimisel ei suudeta ette näha ega läbi mängida kõiki võimalikke elus ette tulevaid olukordi. Põhjaliku häälestamise ja testimise kulud muutuksid viimaks suuremaks tulust.[57] Lisaks, ka seadus, mille masinkeelsest tõlkest haldusrobot peaks juhinduma, on kõike muud kui staatiline. Seda ei korrigeeri ainult uued seadused, kohtupraktikas antavad tõlgendused[58] ja põhiseaduslikkuse järelevalve otsused, vaid õiguse konteksti – ühiskonna – areng. Nõrk tehisintellekt ei ole võimeline neid muutusi ise tajuma ega rakendama.

Peamine küsimus pole siin selles, kas ja mil määral teeb masin vigu. Masin ei tee juriidilisi mõtteoperatsioone üldse. Masinõpe (oma praeguses võimekuses) suudab juriidilist otsust heal juhul ja piisava andmehulga korral vaid statistiliste operatsioonide abil matkida, mitte mõista õiguse sisu ja langetada selle põhjal mõistuspäraseid otsuseid.[59] Just see on aga PS-i § 3 lg 1 ls 1 nõue. Me ei väida, et eksperdi- või nutisüsteem ei suuda mitte ühtegi juriidilist hinnangut asendada, küll aga tuleb nende süsteemide kasutamise korral leida kirjeldatud probleemidele lahendused.

3.5. Kaalutlusõigus ja hindamisruum

Kirjeldatud probleemid teravnevad kaalutlus- ehk diskretsiooniotsuste korral, kus seadus ei kirjuta asutustele ette selget tegutsemisjuhist, näiteks kas teha ettekirjutus ehitise lammutamiseks, millised nõuded kehtestada hangitavale teenusele, kas ja mis tingimuste korral lubada põhjaveeprobleemidega alal turba kaevandamist või kuhu rajada prügila. Teatavasti ei tähenda kaalutlusõigus asutuse jaoks aga volitust meelevaldseteks otsusteks. Ka kaalutlusotsus tuleb langetada õiguse üldpõhimõtteid, seaduse eesmärki ja kõiki üksikjuhtumil olulisi asjaolusid arvestades (HMS § 4 lg 2).[60]

Täielikult inimese määratletud algoritm kaalutlusotsuste programmeerimiseks ei sobi, sest olulised asjaolud ei ole ettenähtavad. Tõsi, kaalumist on lubatud mõningal määral standardida ja üldistada, näiteks halduseeskirjadega, kuid ametnikul peab atüüpilisel juhul olema standardist kõrvalekaldumise õigus ja kohustus.[61] Optimistid aga usuvad, et kuigi vajalik võimekus praegu puudub, suudab jäikade algoritmide asemel just masinõpe oma dünaamiliste kaalumisparameetrite abil varsti lähtuda väärtuspõhimõtetest ja kaalutluspiiridest.[62]

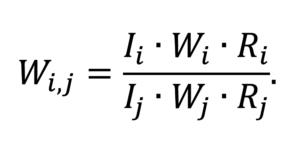

See ei tundu lähiajal realistlik.[63] Esiteks on sedalaadi otsused liiga unikaalsed, et nende mudeldamiseks oleks võimalik luua masinõppes kasutatavaid suuri andmehulki. Teiseks, kaalutlusreeglid ja õiguse üldpõhimõtted võivad vaid esmapilgul näida lihtsate maksiimidena. Neid võib isegi esitada matemaatilise valemina, aga see veel ei taga nende praktilist rakendatavust masinõppes. Toome illustratsiooniks R. Alexy proportsionaalsuse valemi ja püüame selle rakendamist selgitada ohtliku bakteriga nakatatud kalatehase sulgemise ettekirjutuse näitel.

Siin on i ja j otsuse tegemisel kaalutavad printsiibid (praegusel juhul põhiõigused: toidu tarbijate tervis versus ettevõtlusvabadus). Wi,j on printsiibi i konkreetne väärtus j-i suhtes. Selleks, et Veterinaar- ja Toiduamet saaks ettekirjutuse teha, peab i ehk tervis kaaluma üles j-i ehk ettevõtlusvabaduse, teisisõnu Wi,j peab olema >1. I on vastava printsiibi riive intensiivsus, mis väljendub ühe või teise printsiibi taandumisel tekkida võivate kahjude (tarbijate haigestumine või surm, tehase pankrott koos paljude inimeste töötusega) raskuses. W on printsiibi abstraktne väärtus, see näitab, kui tähtsaks me peame rahva tervist ja ettevõtlusvabadust üleüldse. R on vastava printsiibi riivamisel tekkida võiva kahju tõenäosus (oletame näiteks, et tehase töö jätkumise korral ei pruugi toodang tingimata saastuda, aga võib saastuda, kuid tehase sulgemise korral on pankrot kindel).[64]

Ka siis, kui jätta kõrvale muu kriitika selle võrrandi kohta,[65] ei peituks tegelikud raskused mitte arvutustehtes, vaid võrrandi muutujatele õigete väärtuste andmises ning vaidlustes, kas ja mil määral üht või teist printsiipi (õigust) üldse riivatakse, millised asjaolud on tõendatud ning kas need on kaalumisel üldse olulised. Ühe või teise tagajärje tõenäosus (R) võib sõltuda väga erilistest asjaoludest, mida pole taibatud algoritmi õpi- ja tööandmestikes kajastada. Õigusprintsiipide olulisuse (W) ja riive intensiivsuse (I) hindamine aga on väärtusotsused, mille tegemiseks tuleb suuta tunnetada väga mahukat, õiguse ja ühiskonna pika evolutsiooni käigus ladestunud konteksti. Ka inimesest ametnikul ei ole seda teavet otsustamisel iseenesest käepärast, kuid selle puudusega on võimalik toime tulla otsustaja ja menetlusosaliste kommunikatsiooni, kaasava haldusmenetluse käigus (allpool 3.6).

Praegu ja lähitulevikus kättesaadavaid nõrku masinõppetehnoloogiaid iseloomustab just nende piiratus kontekstist ning ka kommunikatsiooni sisust arusaamisel.[66] See kehtib ka määratlemata õigusmõistete (avalik huvi, oluline kahju jne) ja nende sisustamisega kaasneda võiva halduse hindamisruumi korral.[67] Kuigi näiteks oht on KorS-i § 5 lõikes 2 defineeritud kui piisavalt tõenäoliselt aset leidev korrarikkumine (nt toidumürgistus), ei määra seadus kvantitatiivselt kindlaks piisava tõenäosuse taset. See on juriidiline hinnang, mis põhineb taas ka väärtusotsusel ühe või teise hüve olulisuse kohta, mitte ainult kahju tekkimise statistilisel prognoosil.

Keerulise kaalutlus- või hindamisotsuse täielik delegeerimine algoritmile tähendaks meie arvates jämedat kaalutlusviga halduskohtumenetluse seadustiku § 158 lg 3 ls 1 mõttes (pädeva asutuse kaalutlusõiguse teostamata jätmist). Algoritmi saaks rakendada aga abistava vahendina.

3.6. Õiglane menetlus ja uurimispõhimõte

Õiglasel menetlusel – iseäranis kaasarääkimisõigusel (HMS § 40 lg 1) – on tähtis roll nii otsuse sisulise kvaliteedi kui ka puudutatud isikute väärikuse tagamisel.[68] Õiguse sisustamine ja edasiarendamine peab õigusriigis toimuma ausa ning vähemalt puudutatud isiku jaoks avatud arutelu käigus. Suurt hulka inimesi mõjutavates otsustes, nagu ruumiplaneeringud ja keskkonnaload, peab arvamuse avaldamise õigus olema avatud ka üldsusele. Ka sellist diskussiooni suudab nüüdisaegne algoritm (nt väitlusrobot) vaid matkida, mitte tegelikult (mõtestatult) pidada. Masinõppe korral oleks ärakuulamine aga seda enam vajalik, et algoritm ei pruugi olla programmeeritud ega olla õppinud arvestama erakorraliste asjaoludega. Siiski võib just mõni väga haruldane sündmus osutuda õige ennustuse tegemisel määravaks, näiteks jalaluu murdmise korral ei lähe inimene iganädalasesse trenni, kuigi see oleks muidu aastatepikkuse käitumismustri tõttu väga tõenäoline.[69]

Coglianese ja D. Lehr osutavad, et ärakuulamiskohustus on USA õiguses võrdlemisi paindlik ning ilma ärakuulamiseta masinõpe võib teha keskmiselt korrektsemaid otsuseid kui ärakuulamisega inimmenetlus.[70] See pole piisav õigustus. Veaprotsendi hulka sattuv kodanik või ettevõtja ei pea lubama end uinutada kaunil statistikal, vaid tal on õigus nõuda õiguspärast otsust ka enda kaasuses. Eestiski näeb HMS-i § 40 lg 3 ette mitu erandit ärakuulamiskohustusest. Neid erandeid on võimalik eriseadustega lisada, kui ärakuulamise tegelik kasutegur on väike. Üleüldist erandit mis tahes algoritmiliste haldusaktide kohta aga kehtestada ei tohi. Mida suurem on otsustusruum, seda vajalikum on kommunikatsioon menetluses, seega, seda vähem jääb ruumi täisautomaatsetele otsustele, s.t tehisintellekti rakendamisel tuleb puudutatud isikule siiski jätta võimalus ametnikuga suhelda.[71]

Õiguste ja avaliku huvi tõhusa kaitse tagamiseks juhindutakse haldusmenetluses uurimispõhimõttest (HMS § 6) – asutuse kohustusest selgitada oma algatusel välja kõik tähtsad asjaolud. Ka see on algoritmide jaoks väljakutse, sest nad ei saa tegeleda asjaoludega, mida pole süsteemi sisestatud. Veel ei ole kogu meid ümbritsev reaalsus digiteeritud või sensorite abil masinloetav. Masin suudab seetõttu analüüsimisel arvestada vaid tegeliku olustiku fragmente.[72] Inimene aga on suuteline oma algatusel otsima probleemi lahendamiseks andmeid juurde ka allikatest, mida ei ole talle üheski juhendis ette söödetud.

Kui tähtsat infot ei teata, ei vabanda see otsustajat keelunormi-vastase otsuse langetamisel.[73] Saksamaal nõuab sealne seadus seepärast inimametniku sekkumist, kohustades teda vajaduse korral manuaalselt korrigeerima automaatset otsust täiendavaid asjaolusid arvestades.[74] Targa rakendamise korral on siiski ka masinõpet võimalik rakendada uurimispõhimõtte teenistusse, näiteks valides välja maksudeklaratsioone, mida on tarvis allutada põhjalikumale manuaalsele kontrollile.[75]

3.7. Põhjendamine

Ausa menetluse tuumikelement on ka riigivõimu otsuste põhjendamine. Haldusaktis tuleb HMS-i § 56 kohaselt ära märkida haldusakti õiguslik ja faktiline alus (volitusnorm ja selle rakendamist õigustavad asjaolud) ning kaalutlusõigusele tuginemise korral ka vähemalt peamised motiivid erinevate otsustusvariantide hulgast valiku tegemisel (nt miks on vaja tselluloositehast Tartusse ja mitte Narva, või miks tuleb keelata tuulepargi ehitamine).

Tegemist ei ole pelgalt eetilise soovitusega, vaid fundamentaalse põhiseadusliku kohustusega.[76] Õiguse rakendamise volituse võib anda vaid sellisele üksusele, kes suudab tõestada, et otsus on õiguspärane, sh kooskõlas nii otsuse väliste piiride kui ka sisemiste kaalutlusreeglitega. Siin ilmneb era- ja avaliku sektori oluline vahe: vabaduse kasutamist ei pea põhjendama, võimu kasutamist tuleb põhjendada. Maksuotsuse või lammutusettekirjutuse saanud isik ei pea leppima ametniku nõutu sedastusega, et „ei tea miks, aga masin tegi teie kohta sellise otsuse“.

HMS-i § 56 ega ka näiteks MKS-i 462 ei tee põhjendamiskohustusest erandit automaatsetele, sh algoritmilistele haldusotsustele. Niisugune erand ei oleks kooskõlas ka põhiseadusega ega demokraatlikes õigusriikides üldtunnustatud standardiga.[77] Nagu nägime, ei suuda algoritmi loojad ega kasutajad masinõppe läbipaistmatuse tõttu pahatihti seletada roboti otsuseid. USA-s Houstonis kasutati 2011. aastal algoritmilist otsustusprotsessi õpetajatega töölepingute lõpetamisel. Kohtuvaidluse käigus ei suutnud kooli pidaja selgitada algoritmi toimimist, väites, et tal pole selle tehnoloogia üle valdust ega kontrolli.[78] Ka Ühendriikide valitsus on toonud murekohana välja läbipaistmatuse probleemi.[79]

Osa eksperte näeb võimalust lahendada läbipaistmatuse probleem, arendades tehisintellekti abil keeletöötlusprogramme nõnda, et arvuti sünteesiks paljude varasemate põhjenduste analüüsi põhjal juriidilisele argumentatsioonile pealtnäha sarnanevad masinpõhjendused.[80] See meetod kasutaks siiski taas vaid statistikat, mitte õigusteaduse meetoditele vastavat arutluskäiku, tähendades üksnes lubamatu näivuse loomist. Põhjendus aga peab olema ehtne.[81]

Üha enam otsitakse põhjendamiskohustuse täitmiseks masinõppe läbipaistvuse suurendamise võimalusi, lähtudes vastutavuse (accountability) ja selgitatavuse (explainability) põhimõtetest. Selleks nõutakse muu hulgas suuremat juurdepääsu õpi- ja algandmetelele, andmete töötlemisele, algoritmidele endale ja nende õppeprotsessidele.[82] Need üleskutsed põrkuvad aga näiteks ärisaladuse, asutusesisese teabe ja isikuandmete kaitsega, ennekõike aga inimeste võimekusega algoritmide tööd analüüsida. Liiati pole haldusakti põhjendamisel peamine tehniline kirjeldus, kuidas otsus tehti, vaid motiivid, miks tehti just selline otsus, nagu see tehti. Ka inimese tehtud otsuse korral ei huvita meid otsustaja aju töö biokeemilised üksikasjad, vaid tema selgitused. Masinõppe üldise läbipaistvuse suurendamise kasutegur üksikotsuste põhjendamisel on väike.[83]

Alternatiivina on asutud välja arendama nn selgitavat tehisintellekti (xAI). Kuivõrd masinõppe tegelikud matemaatilised protsessid on liiga keerulised ja mahukad, et inimene neid tulemuslikult vahetult uurida suudaks, püütakse ka selle ülesande korral rakendada tehisintellekti, näiteks mudeldada lihtsama ning arusaadavama algoritmiga keerulise rakenduse tööd.[84] On meetodeid, millega püütakse konstrueerida sarnaseim fiktiivne olukord, mille korral algoritm annab teistsuguse vastuse. Selleks jäetakse osa muutujaid kõrvale või muudetakse neist mõnd (nt isiku sugu või vanus) jättes teised muutujad samal ajal konstantseks. Selle võttega saab sõeluda välja otsustamisel kaalukeeleks osutunud kriteeriume.[85] Seegi aga on heal juhul vaid pool teed: tegemist on selgitusega statistilise hinnangu tagamaade kohta, aga mitte juriidilise hinnanguga.[86] See võib olla piisav, kui haldusakti andmisel ongi tarvis lahendada keeruline, kuid matemaatiliselt väljendatav probleem, näiteks prognoosida arengu või sündmuse tõenäosust (nt kaitsealuse liigi populatsiooni suurenemist või vähenemist raudtee rajamise korral).[87]

Sellised hinnangud ja prognoosid on vahel vajalikud, kuid nendega põhjendamiskohustus ei piirdu. Üldjuhul on haldusaktis tarvis näiteks selgitust, miks kohaldatakse õigusnormi x ja mitte y; miks tõlgendatakse seadusesätet viisil a ning mitte b; millised asjaolud on tuvastatud ja miks; miks need asjaolud on kohaldatava õiguse seisukohalt olulised;[88] miks on rakendatav meede vajalik (nt miks tuleb ohtlik ehitis lammutada ega piisa ümberehitamisest). Kõigi nende teemade korral tuleb esitada ka vastuargumendid menetlusosaliste seisukohtadele, mida otsustamisel ei järgitud. Kratt ei saa nende mõtteoperatsioonide kohta adekvaatseid selgitusi anda, sest ta ei soorita neid operatsioone.[89] Kui haldusaktis on tarvis sisulist juriidilist põhjendust, tuleb infotehnoloogia praeguse taseme juures „vooluringi“ lülitada ka inimene.[90]

3.8. Kohtulik kontroll

Seaduslikkuse tagamiseks on soovitatud allutada nii era- kui ka avaliku sektori tehisintellekti rakendused mitmekülgsele järelevalvele (dokumenteerimine, auditeerimine, sertifitseerimine, standardimine).[91] See on vajalik, kuid ei saa asendada kohtulikku kaitset isikute jaoks, kes leiavad, et nende õigused võivad olla rikutud (PS § 15 lg 1, Euroopa inimõiguste ja põhivabaduste kaitse konventsiooni (EIÕK) art 6 ja 13, EL-i põhiõiguste harta (ELPH) art 47). Kui algoritmi abil tehtud haldusotsus varustatakse sisuliste ja tegelike põhjendustega, ei ole õiguskaitse tagamisel põhimõttelist probleemi. Kui säärane põhjendus puudub, tekivad raskused.[91a]

Coglianese ja D. Lehr osutavad kohtuliku kontrolli taandumisele tehniliselt keeruliste küsimuste arutamisel.[92] Algoritmi kasutamine aga ju muudabki otsuse keeruliseks! Algoritmi rakendamine ei või siiski kujuneda universaalseks võluvitsaks, mis vabastab täitevvõimu ükskõik missuguse otsuse kohtu järelevalve alt. Kontrolli lõdvenemisest saame kõnelda vaid neis olukordades, kus see taandub muudel põhjustel ka tehisintellekti kasutamata, näiteks otsuse sisu majandusliku, tehnilise, meditsiinilise vms keerukuse tõttu, kui puudutatud isikute õiguste riive pole ülemäära intensiivne. Seejuures võib keeruline haldusotsus sisaldada erineva kontrolliintensiivsusega elemente.[93] Selles suunas arutleb E. Berman. Ta näeb algoritmidel kasutusvõimalusi seda enam, mida suurem on halduse kaalumisruum. See arutlus tekitab mõneti segadust, sest ei pea silmas seadusega jäetud kaalutlusõiguse ulatust, vaid ka näiteks üldpõhimõtete ja põhiõiguste olulise mõju puudumist. Lõppkokkuvõttes jõuab see järeldusele, et kontroll võib nõrgeneda seal, kus riived pole eriti rasked ja reeglistik on hõre, ning koguni ära langeda seal, kus kellegi õigusi ei puudutata (nt politseipatrullide asukoha määramine).[94] Selle järeldusega võib nõustuda. Üldjuhul säilib halduskohtumenetluses vähemalt ratsionaalsuse (sh proportsionaalsuse) kontroll, see eeldab mingilgi määral sisusse minevat, vähemalt inimese üle kontrollitud haldusotsust ning juriidiliste põhjenduste esitamist, kui tegemist pole massiliste rutiinotsustustega.

Kontrolliprobleemi lahendus ei saa seisneda selles, et haldusasutus teeb kohtule teatavaks üksnes algoritmi sisu ja toorandmed,[95] mille analüüsimiseks peaks kohus omandama ise infotehnoloogilised teadmised või kasutama ekspertide abi. See ei oleks mõistlike menetlusressursside juures mõeldav ega kooskõlas võimuharude põhiseaduslike rollidega (PS § 4). See asetaks esmase vastutuse algoritmi nõuetekohasuse eest kohtule, kuid tegelikult peab see PS-i § 3 ja 14 kohaselt lasuma täitevvõimul. Ei ole vajadust muuta algoritmi kohtuliku kontrolli vahetuks uurimisesemeks.

Pole tingimata tähtis, kas selles on mingis osas andmete moonutusi, kalibreerimisvigu, kallutatust – need puudused ei pruugi lõpptulemust mõjutada. Ka kaebaja ei pea algoritmilise otsuse vaidlustamisel sääraseid vigu tõestama. Mõistlik lahendus ei oleks algoritmi keerukuse kompenseerimine pikema kaebetähtajaga. Ka algoritmiline haldusotsus peab mõistliku aja jooksul omandama lõpliku õigusjõu.[96] Kohtus on tähtis, et algoritmi abil tehtud haldusotsus oleks juriidiliselt õigustatav.

Oma otsuste seaduslikkuses peab kõigepealt veenduma täitevvõim ise ning sellise veendumuse kujunemine peab olema jälgitav ka ilma arvutiteaduslike eriteadmisteta. See tähendab, et tuleb hakata lähtuma nn administratiivsest Turingi testist ehk kodaniku või ettevõtja jaoks ei tohi vähemalt õiguskaitse seisukohast olla vahet, kas täidesaatev riigivõim kasutab tema kohta otsuste tegemisel tehisintellekti või mitte.[97] Algoritmi kasutav asutus võib põhjendamisel kasutada algoritmi abi, kui ta seda suudab. Kui ei, tuleb appi võtta mõistusliku eluvormi esindaja – ametnik.

4. Kokkuvõtte asemel: krati ja peremehe tööjaotus

Haldusotsused on sisu, õigusliku ja faktilise raamistiku ning otsustusprotsessi seisukohast väga erinevad. Valdkonnast ja olukorrast olenevalt on haldusõiguses jäigad standardlahendused, üldistused ning lihtsustused suuremal ja vähemal määral lubatud.[98] Avaliku halduse ülesannete täitmisel on küllalt palju rutiinseid ja selgetele reeglitele alluvaid otsuseid (nt sotsiaaltoetuste ning maksude valdkonnas), mille tegemise võib usaldada arvutile, juhtides selle tööd mitteõppivate või õppivate algoritmidega.[99] Samuti võib iseõppivaid algoritme olla mõistlik kasutada lõikudes, kus riigi otsustusruum on väga suur ning otsuse tegemiseks on tarvis pigem mittejuriidilist analüüsi (nt politseipatrullide asukoha määramine või kaitsealuse populatsiooni modelleerimine).[100] Ühiskonna tähtsamad otsused (nt kuhu tuleb raudtee või kas rajada tuumajaam) ei ole aga rutiinsed ning need ei sobi õpiandmete puudumise tõttu vähemalt mitte tervenisti automaadistamiseks. Need vajavad inimese hinnangut.[101]

Nende äärmuste vahele jäävates olukordades on realistlik oodata krati ja ametniku koostööd, kus rollide ulatus võib olenevalt valdkonnast ja olukorrast tublisti varieeruda:[102]

- rutiinsemate, kuid mitte päris mehaaniliste ning isikule pigem soodsate ja negatiivsete kõrvalmõjudeta haldusotsuste korral, mille andmisel tähtust omavad faktilised asjaolud on algoritmile arusaadavad, võiks leppida täisautomaatsete haldusotsustega. Asjaosaline peaks aga saama soovi korral nõuda otsuse inimlikku ülevaatamist. Menetlustehniliselt on mõeldav anda täisautomaatne haldusakt näiteks esialgse haldusaktina, mille asendamist manuaalse haldusaktiga saab isik taotleda näiteks ühe kuu jooksul;[103]

- mõõduka keerukusastmega haldusotsuse korral võib olla vaja, et haldusotsuse kinnitab ametnik, kuid seejuures tuleb vältida kummitempli fenomeni. Ametnik peaks eelnevalt vaatama üle menetlusosaliste väited ja teiste asutuste arvamused, hindama uurimispõhimõtte alusel asjaolude igakülgsust ning ammendavust, koostama haldusakti põhjendused ja hindama põhjalikult oma valikut. Tehnoloogia arenedes võib ka põhjendamisel loota masina kasvavale abile (et selgitada välja kaalukeeleks osutunud aspektid; koostada põhjenduste mustand või vähemalt selle rutiinsemad osad);

- faktiliselt või õiguslikult keeruliste otsuste korral peab vähemalt enne tugeva tehisintellekti väljaarendamist jääma kandev roll inimesele,[104] kuid õppivate algoritmidega on võimalik hinnata nende otsuste üksikuid koosseisulisi elemente. Ametnikul aga tuleb näiteks vahetult kuulata üle tunnistajad, suhelda vahetult ja inimlikult menetlusosalistega ning langetada põhimõtteline otsus, seda ka põhjendades.

Kõigis neis variantides sobib kvaliteetne masinõpe iseäranis abistama ametnikke neis töölõikudes, kus tuleb prognoosida asjaolusid või sündmusi, mille korral ka inimesel pole tõsikindlat teadmist (nt korrarikkumise tõenäosust). Õigusliku otsuse (nt kas prognoosi tulemus on piisav, et seda saaks vaadelda sekkumist õigustava kvalifitseeritud ohuna) peab aga langetama inimene.[105] Masinõpet võiks olla võimalik rakendada ka väga ebakindlates olukordades, kui mõni otsus tuleb langetada, ent ka ametnik jääks ratsionaalsete põhjenduste esitamisel hätta (pikaajaline mõju keskkonnale).[106] Igal juhul nõuab masinõppe rakendamine haldusülesannete täitmisel asutustelt vastutustunnet ja nii juriidilisi kui ka statistilisi ning infotehnoloogilisi teadmisi, vähemalt sel määral, mida on vaja arendusteenuste adekvaatseks sisseostmiseks ning järelevalveks.[107]

____________________________

* Artikkel peegeldab autorite isiklikku arvamust ega kajasta ühegi institutsiooni ametlikke seisukohti. Täname konsultatsiooni eest masinõppe dotsenti Meelis Kulli (Tartu Ülikool) ja iduettevõtjat Jaak Sarve (Geneto OÜ), veeretamata neile vastutust artikli sisu eest.

[1] Majandus- ja Kommunikatsiooniministeerium (MKM), Eesti riiklik tehisintellekti alane tegevuskava 2019‒2021. ‒ https://www.mkm.ee/sites/default/files/eesti_kratikava_juuli2019.pdf; Riigikantselei/MKM. Eesti tehisintellekti kasutuselevõtu ekspertrühma aruanne, 2019, lk 36 ‒ https://www.riigikantselei.ee/sites/default/files/riigikantselei/strateegiaburoo/eesti_tehisintellekti_kasutuselevotu_eksperdiruhma_aruanne.pdf; MKM. Krattide projekti koduleht. ‒ https://www.kratid.ee/; T. Kerikmäe, M. Minn, R. Pärgmäe. Kuidas elada koos krattidega? – Õiguskeel 2019/4.

[2] K. Lember. Tehisintellekti kasutamine haldusakti andmisel. – Juridica 2019/10, lk 749; K. Lember. Tehisintellekti kasutamine haldusakti andmisel. Magistritöö, Tartu 2019.

[3] Maksukorralduse seaduse (MKS) § 462; keskkonnatasude seaduse (KeTS) § 336; töötuskindlustuse seaduse (TKindlS) § 23 lg 4. Vt ka rahandusministri 14.03.2019 määrus nr 15; keskkonnaministri 20.06.2011 määrus nr 34.

[4] Eesti riiklik tehisintellekti alane tegevuskava 2019‒2021, lk 9 ‒ https://www.mkm.ee/sites/default/files/eesti_kratikava_juuli2019.pdf.

[5] M. Mets. „Töötukassas hakkab sulle robot hüvitist määrama, kui sa töötuks jääd“. – Geenius 7.02.2019; Homme makstakse 79 370 inimesele välja üksi elava pensionäri toetus. ‒ Maaleht, 4.10.2018.

[6] K. Leetaru. A Reminder That Machine Learning Is About Correlations Not Causation. – Forbes 15.01.2019. Vt ka kriitilisi seisukohti seoses riskihinnangutega ennetähtaegsel vabastamisel, RKKKm 1-09-14104.

[7] Vt iseäranis isikuandmete kaitse üldmäärus (IKÜM; Euroopa Parlamendi ja nõukogu määrus (EL) 2016/679) art 22 lg 1 ja lg 2 p „b“.

[8] Näiteks C. Coglianese, D. Lehr. Regulating by Robot: Administrative Decision Making in the Machine-Learning Era. ‒ Geo. L. J. 105 (2017), lk 1147, 1167 jj.

[9] C. Coglianese. Optimizing Regulation for an Optimizing Economy. – University of Pennsylvania Journal of Law and Public Affairs 4 (2018), lk 1.

[10] Vestlusroboteid on maailmas katsetatud nt piiriületajatelt ja varjupaigataotlejatelt ütluste võtmisel, J. Stoklas. Bessere Grenzkontrollen durch Künstliche Intelligenz. ‒ Zeitschrift für Datenschutz (ZD-Aktuell) 2018, 06363; https://www.iborderctrl.eu/The-project; Harvard Ash Center for Democratic Governance and Innovation. Artificial Intelligence for Citizen Services and Government (2017), lk 7; A. Androutsopoulou jt. Transforming the communication between citizens and government through AI-guided chatbots. ‒ Government Information Quarterly 36 (2019), lk 358 jj ‒ https://doi.org/10.1016/j.giq.2018.10.001. Vrd Statistikaameti suhtlusroboti kohta https://www.kratid.ee/statistikaameti-kasutuslugu.

[11] Eestis nt kavandab Muinsuskaitseamet kratte rakendada muuseumide inventeerimisel, https://www.muinsuskaitseamet.ee/et/uudised/kratt-salli-muudab-muuseumiinventuurid-kiiremaks-ja-mugavamaks. Mujal on avaldatud lootust, et tehisintellekt hakkab edaspidi eelsortima ja laiali jagama asutusele saabunud taotlusi või teabenõudeid, L. Guggenberger. Einsatz künstlicher Intelligenz in der Verwaltung. ‒ NVwZ 2019, lk 844, 849.

[12] https://www.kratid.ee/kasutuslood; Eesti Töötukassa. Õlitatud masinavärk: Kuidas tehisintellekt kogu Töötukassa tegevust juhib? – Geenius 08.01.2020; Siseturvalisuse programmi 2020–2023 kavand kooskõlastamiseks (14.11.2019). ‒ http://eelnoud.valitsus.ee/main/mount/docList/184b2e57-2c40-4e41-b5c2-e2e24ab71c30#lb1Z2BiP.

[13] S. Valentine. Impoverished Algorithms: Misguided Governments, Flawed Technologies, and Social Control. ‒ Fordham Urb. L. J. 46 (2019), lk 364, 367.

[14] E. Berman. A Goverment of Law and Not of Machines. – Boston Univ. L. Rev 98 (2018), lk 1290, 1320; C. Coglianese, D. Lehr (viide 8), lk 1161; C. Coglianese, D. Lehr. Transparency and Algorithmic Governance. – Adm. L. Rev. 71 (2019), lk 1, 6 jj.

[15] T. Rademacher. Predictive Policing im deutschen Polizeirecht. – AöR 142 (2017), lk 366; L. Guggelberger (viide 11), lk 848–849; K. Lember. – Juridica 2019 (viide 2), lk 750–751; Conseil d’État 427916: Parcoursup.

[16] Eesti andmeteaduse kommuun. ‒ http://datasci.ee/post/2017/05/25/neli-sonakolksu-masinope-tehisintellekt-suurandmed-andmeteadus/.

[17] M. Koit, T. Roosmaa. Tehisintellekt, 2011, lk 6; M. Herberger. „Künstliche Intelligenz“ und Recht. ‒ NJW 2018, lk 2826; H. Surden. Machine Learning and Law. – Wash. L. Rev. 89 (2014), lk 87, 89; https://www.kratid.ee/mis-on-kratt. Vt ka K. Turk, M. Pild. Kratiga või kratita – see on küsimus. Robotitest ja tehisintellektist tsiviilõiguslikult. – Juridica 2019/1, lk 43, 46.

[18] Nt, et kuni viie aasta vanuste Land Cruiserite kasutajatest 2/3 sissetulek on väiksem kui 1200 eurot kuus, riikliku jälgimise kontekstis; U. Lõhmus. Õigusriik ja inimese õigused. – Tartu, 2018, lk 121. Vrd D. Lehr, P. Ohm. Playing with the Data: What Legal Scholars Should Learn About Machine Learning. – U. C. Davis L. Rev. 51 (2017), lk 653, 672; L. Guggenberger (viide 11), lk 848. Andmekaeve võimaldab muu hulgas tõhusalt teha profiilianalüüse (IKÜM art 4 p 4), kuid andmekaeve ei pruugi sugugi seisneda vaid isikuandmete analüüsis.

[19] E. Berman (viide 14), lk 1277, 1279–1280, 1284, 1286; W. Hoffmann-Riem. Verhaltenssteuerung durch Algorithmen – Eine Herausforderung für das Recht. – AöR 142 (2017), lk 1, 7‒8; Gesellschaft für Informatik. Technische und rechtliche Betrachtungen algorithmischer Entscheidungsverfahren. Studien und Gutachten im Auftrag des Sachverständigenrats für Verbraucherfragen. Berlin: Sachverständigenrat für Verbraucherfragen 2018, lk 30 – http://www.svr-verbraucherfragen.de/wp-content/uploads/GI_Studie_Algorithmenregulierung.pdf.

[20] Paljude seast nt M. A. Lemley, B. Casey. Remedies for Robots. – Univ. of Chicago L. Rev. 86 (2019), lk 1311, 1312; M. Finck, Automated Decision-Making and Administrative Law, teoses: P. Cane jt (toim.), Oxford Handbook of Comparative Administrative Law, Oxford: Oxford University Press (ilmumas) ‒ https://papers.ssrn.com/sol3/papers.cfm?abstract_id=3433684 (2019), lk 2.

[21] Vrd M. Koit, T. Roosmaa. Tehisintellekt, Tartu: Tartu Ülikool 2011, lk 194; Eesti andmeteaduse kommuun. ‒ http://datasci.ee/post/2017/05/25/neli-sonakolksu-masinope-tehisintellekt-suurandmed-andmeteadus/; E. Berman (viide 14), lk 1279, 1284–1285; D. Lehr, P. Ohm (viide 18), lk 671; Gesellschaft für Informatik (viide 19), lk 30.

[22] Inimese loodud programmi asemel on intelligentse süsteemi „otsustusreegel“ seetõttu pigem matemaatiline tõenäosusfunktsioon, T. Wischmeyer. Regulierung intelligente Systeme. – AöR 143 (2018), lk 1, 47. Tõenäosusfunktsioon näitab tõenäosust, et otsitav (juhuslik) väärtus on võrdne mingi kindla väärtustega, nt et me saame täringuid visates kuusi, https://de.wikipedia.org/wiki/Wahrscheinlichkeitsfunktion. Lihtsaima iseõppiva mudeli – lineaarse regressiooni – üldistatud valem näeb välja selline:

Siin on y otsitav väljundmuutuja, mis arvutatakse sisendmuutujate x1, …, xn alusel, arvestades õppimisel ümber kalibreeritavaid kaaluparameetreid w1, …, wn. Lineaarse regressiooni abil saab nt prognoosida eluruumi väärtust, kui on teada selle pindala, tubade arv ja kaugus kesklinnast. Iseõppivate algoritmide tegelik matemaatika on hulka keerulisem. See põhineb paljumõõtmelistel vektoritel ja komplekssetel mudelitel, kus on omavahel ühendatud suur hulk regressioonivõrrandeid. Näiteks tehisnärvivõrkude korral jäljendab võrrandite struktuur närvirakkude seoseid inimese ajus, Gesellschaft für Informatik (viide 19), lk 31, 34.

[23] Gesellschaft für Informatik (viide 19), lk 31; M. A. Lemley, B. Casey (viide 20), lk 1324–1325; C. Coglianese, D. Lehr (viide 14), lk 15; T. Wischmeyer (viide 22), lk 12; D. Lehr, P. Ohm (viide 18), lk 671; J. Cobbe. Administrative Law and the Machines of Goverment: Judicial Review of Automated Public-Sector Decision-Making. – Legal Studies 39 (2019), lk 636. Juhendamiseta masinõppe korral väljundandmetega õpiandmeid ei kasutata, algoritm peab andmestikes peituvad seosed ise üles leidma, A. Berman (viide 14), lk 1287.

[24] Vrd K. Lember. Magistritöö (viide 2), lk 13–14.

[25] Vt Eesti Töötukassa otsuste kohta ka M. Mets (viide 5).

[26] A. Guckelberger. Öffentliche Verwaltung im Zeitalter der Digitalisierung, Baden-Baden: Nomos 2019, lk 484 jj.

[27] Politsei- ja Piirivalveameti andmeladu on nimetatud maailmatasemel analüüsi võimaldavaks süsteemiks, https://issuu.com/ajakiri_radar/docs/radar_19/14. Maksu- ja Tolliameti andmelao kohta vt juba „Maksuamet ühise IT-süsteemiga rahul“. ‒ Äripäev, 9.05.2003.

[28] W. Hoffmann-Riem. Rechtliche Rahmenbedingungen für und regulative Herausforderungen durch Big Data, teoses: W. Hoffmann-Riem (toim). Big Data – Regulative Herausforderungen, Nomos: Baden-Baden 2018, lk 20; W. Hoffmann-Riem (viide 19), lk 13; M. Finck (viide 20), lk 2, 11; T. Wischmeyer (viide 22), lk 10, 13–14, sh viide 48, lk 17–18, 24; C. Coglianese, D. Lehr (viide 8), lk 1156–1159.

[29] A. Deeks. The Judicial Demand for Explainable Artificial Intelligence. – Columbia L. Rev. 119 (2019), lk 1829, 1834; M. Finck (viide 20), lk 9; C. Coglianese, D. Lehr (viide 14), lk 17; J. Burrell. How the machine „thinks“: Understanding opacity in machine learning algorithms. – Big Data & Society 3 (2016) 1, lk 3; J. Tomlinson, K. Sheridan, A. Harkens. Proving Public Law Error in Automated Decision-Making Systems. – https://ssrn.com/abstract=3476657 (2019), lk 10. Isikuandmete turvaliseks analüüsiks, s.t musta kasti efekti suurendamiseks, on Eestis nt loodud Sharemind’i tehnoloogia, D. Bogdanov. Sharemind: programmable secure computations with practical applications. Tartu Ülikooli Kirjastus 2013.

[30] D. Lehr, P. Ohm (viide 18), lk 678; T. Wischmeyer (viide 22), lk 16, 33.

[31] Tehisintellekti ekspertrühma aruanne (viide 1), lk 19; C. Coglianese, D. Lehr (viide 8), lk 1157; D. Lehr, P. Ohm (viide 18), lk 681; E. Berman (viide 14), lk 1302; C. Weyerer, P. F. Langer. Garbage In, Garbage Out: The Vicious Cycle of AI-Based Discrimination in the Public Sector. – Proceedings of the 20th Annual International Conference on Digital Government Research (2019), lk 509 jj.

[32] C. Coglianese, D. Lehr (viide 8), lk 1167.

[33] Näiteks kas retsidiivsuse prognoosimisel huvitab meid uue kuriteo toimepanemise tõenäosus kolme, viie või kümne aasta jooksul; millise muutuja abil mõõta parimat ametnikukandidaati avalikul konkursil.

[34] E. Berman (viide 14), lk 1305 jj; 1325 jj; D. Lehr, P. Ohm (viide 18), lk 669 jj; J. Burrell (viide 29), lk 7.

[35] C. Coglianese, D. Lehr (viide 14), lk 32 jj.

[36] Vt nende riskide kohta lähemalt allpool 3.5. Vrd kohta M. Schröder. Rahmenbedingungen der Digitalisierung der Verwaltung. – Verwaltungsarchiv 110 (2019), lk 328, 347.

[37] W. Hoffmann-Riem (viide 19), lk 24–25; A. Guckelberger (viide 26), lk 410; C. Krönke, Vergaberecht als Digitalisierungsfolgenrecht. Zugleich ein Beitrag zur Theorie des Vergaberechts. – Die Verwaltung 52 (2019), lk 65; M. Finck (viide 20), lk 10.

[38] E. Berman (viide 14), lk 1326; T. Wischmeyer (viide 22), lk 26 jj; M. Finck (viide 20), lk 11; L. Guggenberger (viide 11), lk 847; H. Steege. Algorithmenbasierte Diskriminierung durch Einsatz von Künstlicher Intelligenz. – MultiMedia und Recht 2019, lk 716.

[39] Vrd M. Schröder (viide 36), lk 343. Nii ka Austraalias, M. Finck (viide 20), lk 18.

[40] T. Wischmeyer (viide 22), lk 7–8, 41. Ka IKÜM art 22 lubab isikuandmete töötlemisel täisautomaatseid otsuseid langetada vaid erandina – lepingu täitmiseks, seaduses sätestatud juhtudel või isiku nõusolekul.

[41] Näiteks Sotsiaalkindlustusameti infosüsteemi SKAIS2 saaga kohta https://www.err.ee/613092/skais2-projekti-labikukkumise-kronoloogia.

[42] Märksa kitsama rakendusalaga on KeTS § 336 lg-d 1 ja 3, TKindlS § 23 lg 4. Vt seoses kaalutlusõigusega ka allpool viide 63.

[43] Vrd ettepanek täiendada haldusmenetluse seaduse § 51 lõikega 1 „Haldusorgan võib anda haldusakti ja dokumendi automatiseeritult, ilma haldusorgani nimel tegutseva inimese vahetu sekkumiseta (edaspidi automaatne haldusakt ja dokument)“, T. Kerikmäe jt. Autonoomsete intelligentsete tehnoloogiate kasutamisega seotud küsimuste reguleerimiseks vajalike õigusloome probleemide tuvastamine ja lahendusettepanekute tegemine, III etapi aruanne (2019), lk 6–7.

[44] Bundesministerium des Inneren. Automatisiert erlassene Verwaltungsakte und Bekanntgabe über Internetplattformen – Fortentwicklung des Verfahrensrechts im Zeichen der Digitalisierung: Wie können rechtsstaatliche Standards gewahrt werden? – NVwZ 2015, lk 1114, 1116–1117.

[45] Enamik liiklusreegleid on oma täpsuse tõttu isesõitvale autole ilmselt selgeksõpetatavad, kuid ka liikluses tuleb ette dilemmasid, millele ei saa determineeritud vastust anda, vt M. A. Lemley, B. Casey (viide 20), lk 1311, 1329 jj. Lisaks on masinale keeruline õpetada selgeks olukordi, kus tuleb reeglist, nt punase tulega sõitmise keelust, teha erand, samas, lk 1349.

[46] E. Berman (viide 14), lk 1329; A. Guckelberger (viide 11), lk 367–370. Vrd aga M. Maksing. Kohtupraktika ühtlustamise võimalustest infotehnoloogiliste lahenduste abil. Magistritöö, Tallinn: Tartu Ülikool 2017, lk 25.

[47] L. Reisberg. Semiotic model for the interpretation of undefined legal concepts and filling legal gaps, Tartu: Tartu Ülikooli Kirjastus 2019, lk 170–173; K. Larenz, C.-W. Canaris. Methodenlehre der Rechtswissenschaft, Berlin: Springer 1995, lk 26; K. N. Kotsoglou. Subsumtionsautomat 2.0: Über die (Un-)Möglichkeit einer Algorithmisierung der Rechtserzeugung. – JZ 2014, lk 451, 452–454; R. Narits. Õiguse entsüklopeedia, Tallinn: Tartu Ülikool 1995, lk 68 jj; R. Narits. Õigusteaduse metodoloogia I, Tallinn, 1997, lk 84 jj.

[48] Vt selle eristuse kohta N. Luhmann. Das Recht der Gesellschaft, Frankfurt am Main: Suhrkamp 2018, lk 195 jj.

[49] Otsustus, kas kaasuse elulised asjaolud vastavad õigusnormis nimetatud kohaldamiseeldustele (normi teokoosseisule), R. Narits. Õiguse entsüklopeedia, Tallinn: Tartu Ülikool 1995, lk 73.

[50] Põllumajandusloomade pidamisele esitatavate üldiste nõuete näitel RKHKo 3-15-443/54, p 12.

[51] Vrd C. Coglianese, D. Lehr (viide 14), lk 14; E. Berman (viide 14), lk 1351; K. N. Kotsoglou (viide 47), lk 453; M. Herberger (viide 17), lk 2829.

[52] Lisaks tuleb siin veel arvestada, et isegi kui keegi suudaks kogu kohtupraktika teisendada algoritmi õpiandmeteks, tuleb sedagi esmalt tõlgendada, sest ka kohtuotsused on kirjutatud loomulikus keeles.

[53] See võiks olla hea õiguskindluse seisukohast, aga oleks vastuvõetamatu õigluse vaatenurgast, vrd A. Kaufmann. Rechtsphilosophie, München: Beck 1997, lk 122.

[54] E. Berman (viide 14), lk 1315; vrd F. Pasquale. A Rule of Persons, Not Machines: The Limits of Legal Automation. – G. Wachington L. Rev. 87 (2019), lk 1, 48; vrd A. Adrian. Der Richterautomat ist möglich – Semantik ist nur eine Illusion. – Rechtstheorie 48 (2017), lk 77, 87; P. Enders. Einsatz künstlicher Intelligenz bei juristischer Entscheidungsfindung. – JA 2018, lk 721, 726.

[55] E. Berman (viide 14), lk 1331. A. Adrian osutab laboris juba katsetatavatele loomuliku keele töötlemise süsteemidele, mis suudavad leida statistilisi seoseid kohtuotsuste, teadusartiklite jms õigustekstide „keelekvantide“ vahel, (viide 54), lk 188 jj. Meie arvates jääb sellest õiguse mõistuspäraseks rakendamiseks väheks.

[56] T. Wischmeyer (viide 22), lk 334.

[57] E. Berman (viide 14), lk 1338.

[58] Kaalutlusõiguse kontekstis K. Lember, Magistritöö (viide 2), lk 53.

[59] Arvuti töötleb õigusteksti kui andmeid, mitte informatsiooni, K. N. Kotsoglou, JZ 2014, lk 454. A. Adrian nt väidab, et ka inimene suudab loomuliku keele tähenduse mõistmist ainult teeselda ning üleüldse on semantika ainult illusioon, mistõttu inimese asendamine arvutiga ei tekita põhimõttelisi probleeme (2017), lk 91. Nende filosoofiliste väidete analüüsiks pole selles artiklis võimalust. Lähtume sellest, et inimesel on teadvus ning inimene suudab loomuliku keele lausete, sh seaduse sätete tähendusest aru saada, s.t seda enda teadvusega seostada.

[60] Vt nt K. Merusk, I. Pilving. Halduskohtumenetluse seadustik. Kommenteeritud väljaanne, Tallinn: Juura 2013, § 158 komm. F.

[61] RKHKo 3-3-1-72-13, p 21; RKHKo 3-3-1-81-07, p 13-14. Vrd M. Schröder (viide 36), lk 333; A. Guckelberger (viide 26), lk 373.

[62] Vt L. Guggenbergeri toodud allikaid (viide 11), lk 848.

[63] Ka nt MKS-i § 462 kehtestamisel ei pidanud eelnõu autorid võimalikuks anda automaatseid haldusakte kaalutlusõiguse korral, maksukorralduse seaduse muutmise ja sellega seoses teiste seaduste muutmise seaduse eelnõu (675 SE) seletuskiri, lk 36. Seaduse tekstis aga seda piirangut ei nimetatud.

[64] Vt R. Alexy. Constitutional Rights, Proportionality, and Argumentation. Avalik loeng Tartu Ülikoolis 10. detsembril 2019. ‒ https://www.uttv.ee/naita?id=29148; T. Mori. Wirkt in der Abwägung wirklich das formelle Prinzip? Eine Kritik an der Deutung verfassungsgerichtlicher Entscheidungen durch Robert Alexy. – Der Staat 58 (2019), lk 555, 561.

[65] T. Mori nt toob kohtupraktikast näiteid, millega see valem ei haaku, samas, lk 562.

[66] Vrd C. Coglianese, D. Lehr (viide 8), lk 1218; J. Cobbe. Administrative Law and the Machines of Government: Judicial Review of Automated Public-Sector Decision-Making (2018). ‒ https://ssrn.com/abstract=3226913, lk 20; A. von Graevenitz, „Zwei mal Zwei ist Grün“ – Mensch und KI im Vergleich, ZRP 2018, lk 238, 240. Vt ka Ü. Madise, Põhiseaduse vaimust ja võimust muutuvas ühiskonnas, teoses: T. Soomre (toim.), Teadusmõte Eestis IX. Teadus ja ühiskond, 2018, lk 138. Väärtusotsuste kohta R. Narits. Eesti õiguskord ja väärtusjurisprudents. – Juridica 1998/1, lk 2.

[67] Nii ka A. Guckelberger (viide 26), lk 389 jj; T. Wischmeyer (viide 22), lk 17‒18. Vrd A. Berger, Der automatisierte Verwaltungsakt. ‒ NVwZ 2018, lk 1260, 1263.

[68] Vt selle kohta nt E. Andresen, V. Olle, teoses: J. Sootak (toim.). Õigus igaühele, Juura: Tallinn 2014, lk 149–150; I. Pilving, teoses: A. Aedmaa jt. Haldusmenetluse käsiraamat. Tartu: Tartu Ülikooli Kirjastus 2004, lk 215 jj. Isikuandmete automaatse töötlemise korral IKÜM pp 71 lg 1.

[69] E. Berman (viide 14), lk 1323; A. Guckelberger (viide 26), lk 396.

[70] Viide 8, lk 1186.

[71] Nii ka 675 SE seletuskiri (viide 63), lk 36. Vt veel RKHKo 3-3-1-76-14, p 14 seoses distsiplinaarkaristustega.

[72] T. Rademacher (viide 15), 383; A. Adrian (viide 54), lk 77, 86.

[73] Seoses hankelepingu sõlmimise keeluga, RKHKo 3-3-1-7-17, p 11. Kaalutlusõiguse puhul võib mitteteadmine vabandada, kui isikul oli võimalus asutust asjaolust teavitada – riigist lahkumise ettekirjutusega seoses, RKHKo 3-18-1891/46, p 19.

[74] § 24 lg 1 ls 3 Verwaltungsfahrensgesetz (VwVfG). Selle kohta F. Kopp/U. Ramsauer, Verwaltungsverfahrensgesetz. Kommentar, München: Beck 2019, § 24 änr 8; L. Guggenberger (viide 11), lk 847.

[75] M. Belkin. Maksuamet hakkab tehisintellekti abiga ümbrikupalga maksjaid püüdma. – Geenius 06.01.2020.

[76] Põhjendamiskohustus tuleneb PS § 13 lg-st 2 ja § 15 lg 1 ls-st 1, samuti ELPH art 41 lg-st 2. Vt lähemalt N. Parrest, teoses: A. Aedmaa jt (viide 68), lk 299 jj. Lisaks kõigele muule ei tasu täieliku läbipaistmatuse korral loota laiemat ühiskondlikku toetust masinotsustele, selle asemel võtab maad manipulatsioonide või lausa „süvariigi“ kahtlus, vt M. Herberger (viide 17), lk 2828.

[77] Saksamaal § 39 VwVfG, Prantsusmaal art L211-5, Code des Relations entre le Public et l’Administration; Ühendkuningriigis House of Lords: R v. Secretary of State for the Home Department, ex parte Doody (1993) 3 All E.R. 92; Euroopa Liit: ELTL art 296 lg 2; EIÕK art 6 kohta EIKo 13616/88: Hentrich/Prantsusmaa (1994), p 56; H. Palmer Olsen jt. What’s in the Box? The Legal Requirement of Explainability in Computationally Aided Decision-Making in Public Administration (2019). ‒ https://ssrn.com/abstract=3402974, lk 22.

[78] United States District Court, S.D. Texas, Houston Division: Hous. fed’n of Teachers. – 251 F. Supp. 3d (2017), lk 1168. Samuti pole suudetud selgitada algoritme, mis soovitavad politseipatrullidel teatud isikuid peatada ja kontrollida. Nende näidete kohta vt S. Valentine (viide 13), lk 372–373, 367.

[79] C. Cath jt. Artificial Intelligence and the ’Good Society’: the US, EU, and UK approach. ‒ Science and Engineering Ethics 24 (2017), lk 9.

[80] H. Palmer Olsen jt (viide 77), lk 23–24. Näiteks Jaapanis aitab tehisintellekt parlamendiliikmetel koostada vastuseid kodanike märgukirjadele, Harvard Ash Center (viide 10), lk 8. IBM väitlusroboti kohta, K. Lember. Magistritöö (viide 2), lk 38. Vt selle meetodi kohta ka F. Pasquale (viide 54), lk 49 jj.

[81] RKHKo 3-3-1-29-12, p 20. Pole aga põhjust välistada sel viisil koostatud teksti kasutamist põhjenduste esialgse mustandina, kui ametnik kontrollib mustandi üle sisuliselt ja hoolikalt. Vt ka RKHKo 3-17-1110/84, p 18, kus kolleegium selgitas, et haldusotsuse põhjendamine ei tohi piirduda normide mehhaanilise kopeerimisega.

[82] Täiendavate viidetega M. Herberger (viide 17), lk 2827–2828; K. Lember. Magistritöö (viide 2), lk 36; samuti IKÜM pp 71.

[83] L. Edwards, M. Veale. Slave to the Algorithm: Why a Right to an Explanation Is Probably Not the Remedy You Are Looking for. ‒ Duke L. & Tech. Rev. 16 (2017–2018), lk 18, 43, 56, 67; E. Berman (viide 14), lk 1316–1317; W. Hoffmann-Riem (viide 28), lk 60. Vangla töömeetodite avaldamise piirangu kohta Tartu RKK 3-16-418, p 12.

[84] A. Deeks (viide 29), lk 1834; E. Berman (viide 14), lk 1317; L. Edwards, M. Veale (viide 83), lk 61 jj; M. Finck (viide 20), lk 15. Teise seas nt A. Adadi, M. Berrada. Peeking Inside the Black-Box: A Survey on Explainable Artificial Intelligence (XAI). – IEEE Access 2018/6, lk 52138 jj ‒ https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=8466590.

[85] C. Coglianese, D. Lehr (viide 14), lk 52; Deeks (viide 29), lk 1836; T. Wischmeyer (viide 22), lk 61–62.

[86] L. Guggenberger (viide 11), lk 849; K. D. Ashley. Artificial Intelligence and Legal Analytics: New Tools for Law Practice in the Digital Age. Cambridge University Press 2017, lk 3.

[87] See võib olla oluline kallutatuse kindlakstegemisel, aga kallutatus ei ole kaugeltki ainus tahk, millele haldusotsuse kontrollimisel tuleb tähelepanu pöörata.

[88] Niinimetatud faktilise ja õigusliku põhjenduse loogiline sidumine, turul kauplemise piirangute näitel RKHKo 3-3-1-66-03, p 19.

[89] Väga õigesti K. Lember. Magistritöö (viide 2), lk 53.

[90] Võimalike mudelite kohta allpool p 4.

[91] W. Hofmann-Riem (viide 28), lk 60 jj.

91a Ennetähtaegsel vabastamisel kasutatud põhistamata poolautomaatsed ohuhinnangud on kohtud „hukule määranud“, märkides, et need „ei maksa kohtu silmis midagi“, Tartu RKK 1-13-8065, p 26, Tartu MK 1-13-7295, p 14.

[92] C. Coglianese, D. Lehr (viide 14), lk 44.

[93] Näiteks välismaalasest korduvkurjategija ohtlikkuse hindamisel ei ole politseil kontrollivaba hindamisruumi, kui ta plaanib sellisele isikule teha riigist lahkumise ettekirjutust. Ohtlikkuse hindamine ei ole üksnes uue õigusrikkumise statistiline prognoos, vaid ka sellele tuginev juriidiline hindamisotsus – kas tõenäosus vastab seadusandja ettekujutusele kvantitatiivselt määratlemata lävendist. Küll aga on kohtulik kontroll piiratud tagajärje kaalumisel (kas ettekirjutus teha ja kui pika sissesõidukeeluga), RKHKo 3-17-1545/18, p 28. Vt ka I. Pilving. Kui range peab olema halduskohus? – RiTo 2019/39, lk 61, 64 jj.

[94] Viide 14, lk 1277, 1283.

[95] M. Schröder (viide 36), lk 342. Vajaduse korral tuleb kohtule siiski juurdepääs sellele teabele tagada, sõltumata ärisaladuse kaitsmise huvist. Kohtul on võimalus aga piirata teiste menetlusosaliste juurdepääsu ärisaladusele (HKMS § 88 lg 2).

[96] Vrd aga J. Cobbe (viide 66), lk 8.

[97] H. Palmer Olsen jt (viide 77), lk 23.

[98] T. Wischmeyer (viide 22), lk 34.

[99] A. Guckelberger (viide 26), lk 386–387.

[100] E. Berman (viide 14).

[101] C. Coglianese, D. Lehr (viide 14), lk 30; C. Coglianese, D. Lehr (viide 8), lk 1214.

[102] Nii ka A. Guckelberger (viide 26), lk 386.

[103] Art L311-3-1 lg 2, code des relations entre le public et l’administration. Võimaliku lahendusena näeb seda ka K. Lember. Magistritöö (viide 2), lk 40.

[104] T. Wischmeyer (viide 22), lk 41.

[105] Ka ametniku prognoosotsuste korral on määrav roll just senisel praktilisel kogemusel, T. Rademacher (viide 15), lk 378, 384.

[106] Vrd A. Vermeule. Rationally Arbitrary Decisions in Administrative Law. – The Journal of Legal Studies 44 (2015), lk 475.

[107] C. Coglianese, D. Lehr (viide 14), lk 30.